Zhiyuan Robobrain 2.0+Roboos 2.0 Sen。

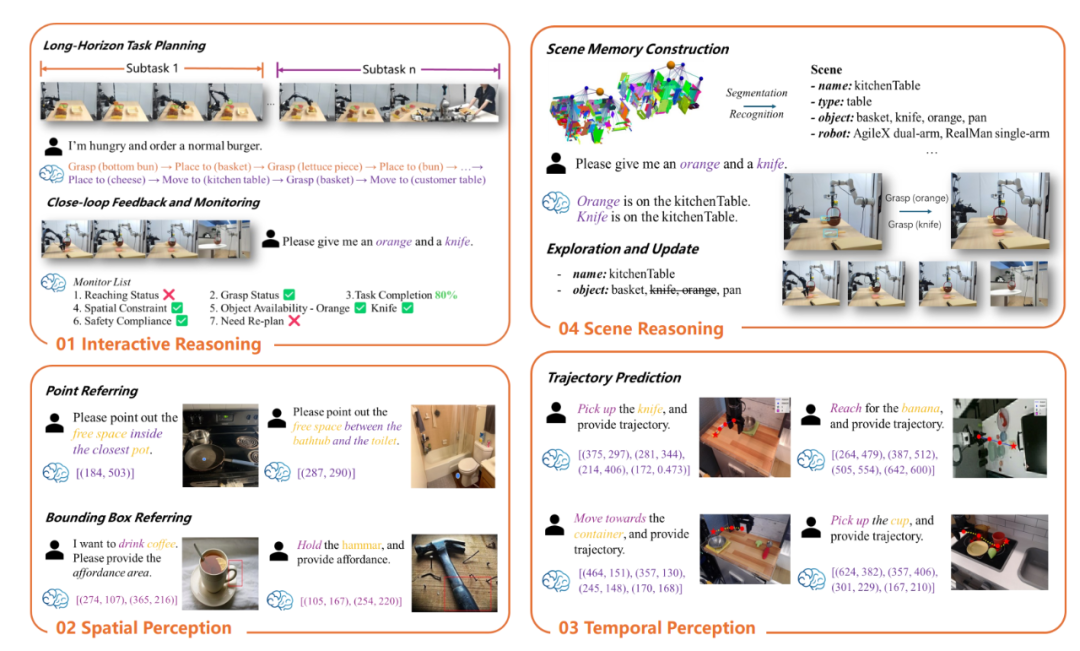

最近,Zhiyuan研究所推出了Robobrain 2.0 32b版本的化身大脑,并为抢劫2.0的独立版本(大规模协作框架和跨性别学的大脑)推出了独立版本。 Robobrain 2.0已完全建立了许多授权和具体的智能参考点的注册,这是一种“化身的通用大脑”,将意识,推理和计划整合在真实的物理环境中,而版本32B则在时空上的认知进步。上面启动的7B版本具有紧凑,高效的模型构建。它的光设计完全适应边缘设备的实现需求,并且可以在低收入环境中稳定。同时,与开源和封闭代码模型相比,性能仍然很强。作为第一个代码框架Tobasas Intelligente del Mundo,Roboos 2.0创新整合了MCP和体系结构的协议s没有服务器来实现光线实现,并在智能大脑和异质本体论之间打开协作路线。同时,它推出了独立的产品线和Koboskillskillskillskillskillskillskillskillskillskillskills,它们提供了智能一致的适应能力,并通过深层集成可以单击Roboticskills模块,通过深层集成,标准化界面有效地消除了制造过程中的差异。同时,他立即启动了盒子的反射,承认三行指令并迅速实施,这使开发人员可以有效地构建智能机器人系统。内置的大脑与大型和小脑协作之间的双运动连接框架“独立智能”到“团体智能”,它加速了智能技术实验室体现的智能技术实验室的运动,这使其成为开放和有效的集成并形成一个智能的生态系统。 1。Robobrain2.0打破了三个特征的瓶颈。模块化体系结构改善了复杂和化身的推理。当涉及到真正的物理环境时,有三个主要的瓶颈。空间理解的精度不足,时间较弱以及缺乏长链推理能力。 Robbrain 2.0通过这三个关键功能实现了不可或缺的进步,从而显着提高了他们对复杂和体现任务的理解和执行。空间理解:点和划界框的精确预测:根据复杂说明在图像中查找对象或区域的能力。我了解空间关系:了解对象之间的相对位置和方向。空间推断:基于场景图形的构造和实时更新,以执行复杂的3D空间推断。时间建模:长期计划:实施多个步骤任务计划的能力支持长期目标。闭路交互:接受基于反馈的动态调整,以适应动态环境。多个代理的协作:您可以协调多个代理的行为和完全复杂的任务。长链推断:链推断:可以执行多个步骤的推断,以便为复杂的任务允许步骤 - 逐步解决方案。因果逻辑:提取复杂指令的因果逻辑并与环境状态保持一致的能力。决策的透明度:支持生成推理过程详细描述的能力,以及决策的透明度和解释性。 Robobrain的一般描述呈现照片Robobrain 2.0使用模块化编码器解码器的体系结构在感知,推理和规划复杂和具体的任务中实现统一性。与传统视觉语言模型(VLM)不同,该模型的重点是通用静态视觉问题和答案(VQA),Robobrain 2.0专注于合并推理任务,例如空间感知,临时建模和长链的因果推理,同时保持强大的通用VQA的强大功能。该体系结构在集成的多模式标记序列中编码高分辨率图像,多个视觉条目,视频框架,语言说明和场景图形序列,用于积分处理。 Robraiaritectura del modethe n2.0图2。Robobrain2.0确认了多模式数据集的存款和相培训策略Robobrain 2.0信任一组全面而多样的多模式数据,整合了多个视频序列,基于高分辨率图像,高视幻像序列,场景序列,场景序列,3D语言模式和复杂的语言数据和复杂的语言数据和复杂的语言数据和复杂的语言数据。特定的环境。该多模式数据集侧重于三个中央区域,并为复杂的物理场景提供了强有力的支持。一般的多模式理解ding:整合标准的视觉问题和答案,区域咨询,OCR视觉问题和答案以及多个视觉对话回合,以优化言语表达的多样性和语义一致性。通过视觉语言互动的丰富数据,改善了模型对Tacomplex区域的理解和响应能力,可以适应各种场景,从简单的问题和答案到多个对话回合。空间感知:承认高精度对象的定位,有限的图像的预测以及对象的功能识别,涵盖了复杂的内部和外部视觉场景和3D空间推理,机器人精确地分析了对象的关系,空间属性,场景的上下文,挑战和多个位置的互动,并置换了定位。时间建模:接收多模式数据,较长的任务计划,闭路反馈M多种代理的机能和协作,改进任务模型的分解,动态环境中动作序列的预测和实际时间交互,保证在复杂的物理场景中制定决策,灵活的协作以及任务的有效执行。 Robbrain 2.0改善了互动推理的机器人,多种代理的协作以及在特定环境中计划的有效任务,具有出色的多模式识别,出色的空间推理和强大的长期计划能力,在复杂的物理场景中帮助智能看法和决策。 Robobrain 2.0训练数据集Robobrain 2.0用于大规模的Zhiyuanel培训框架的Effaza用于使用三阶段的渐进式训练过程,使用国旗量表进行大规模分布式训练。阶段1:第1阶段的基本空间学习,Robobrain 2.0着重于创建空间基本能力感知和时间理解。该模型通过一个出色的Cmultimodal数据进行了培训,该数据对图形数据,视频问题和答案以及参考识别理解任务进行了密集评分。在通过训练的这个阶段,该模型可以处理静态图像和视频传输,掌握基本的空间关系和对象运动事件,并为后续且更复杂的任务建立坚实的基础。第2阶段:在第二个合并阶段中的时空扩展,Robobrain 2.0进一步提高了通过引入多个高分辨率图像,第一人称视频数据以及导航和交互任务的任务中的空间建模功能。该模型学会了处理长时间的空间信息序列,并支持多种代理,在动态环境中的长期计划和自适应决策的协调。这个训练阶段允许模型将更好的历史视觉信息与当前说明相结合,这取得了更多在动态和互动环境中,一致的长期计划和对鲁棒场景的理解。第3阶段:在本质化上下文中的第三阶段的推论Robobrain 2.0进一步提高了复杂任务中的推理能力,并通过改进的调整和良好的调整体现。该模型是使用多个推理训练的,这些示例涵盖了诸如长期任务计划,操作预测,闭路交互,对时空和多次协作的理解等任务。在这个训练阶段,该模型可以生成推理链,并逐步支持复杂任务的逐步推理和决策,从而实现更有效,更精确的推理和计划功能。 Robbrain 2.0使用FlangeValm Frameworkm完全验证空间和时间推理功能。空间推断:眨眼(83.95),简历台(85.75),其中2Place(73.59)和Robobrain-32b/7b-2.0,Sota是RE山顶上获得了精确对象的位置,对定界线绘画和空间参考的预测,诸如双子座和GPT-4O之类的Buse线。时间推理:多个机器人计划(80.33),Egoplan 2(57.23),Robobench(72.16),出色的远程计划,闭路电路反馈和多个代理的协作能力,导致了QWEN2.5-VL,Claude,Claude和其他模型。 Robobrain 2.0-32b在空间和时间推理参考点(例如闪烁的空间,Robospia和参考库)上实现了最大的性能。 Robobrain 2.0 7b模型分别以83.95和85.75点的速度超过了Banco眨眼和CV的参考点。 Robobrain 2.0 32B模型Modelrobbrain 2.0 7b用Robospial,Ref-Spatial Banch,SAT,其中2Place和ShareBot-Bench实现了SOTA的进步。 Robobrain 2.0 7b模型首次以多机枪计划中的81.50分进行了分类,其次是Robobrain 2.0 32B,分别为80.33点。 Robobrain 2.0 32b比GPT-4O等基线具有显着优势,领导了EGO 2计划(57.23分)。 Robobrain 2.0 7B模型在抢劫银行中进行了分类72.16,已使用双模型更新,以实现高性能和更新的性能限制。双引擎Robobrain 2.0和Robbery 2.0允许抢劫2.0 Berina的大型合作框架和啤酒的多个Conlogios计划能力。 Robbrain 2.0允许跨社区任务支持多种情况的实施,例如超市,厨房和房屋。交叉方向,大脑协作框架2.0是基于智能SaaS平台的Mundo的第一个开瓶器,并结合了一个原始框架,该框架承认实现了轻型和独特的服务器轻机器人本体。同时,Roboos 2.0也是世界上第一个支持MCP的Cross -Brain合作框架,目的是建立App Store融合情报领域的生态系统。盗窃2.0实现了针对小脑技能的大脑云和适应性登记机制的优化推断的开发,从而大大降低了发展阈值。在典型的情况下,所涉及的代码数量仅是传统手动注册方法的1/10。 Marco Roboos 2.0(SaaS + MCP模式)。 Roboos是一个小脑等级系统,用于多个机器人的协作,其中包括三个主要组件。 (a)基于云计算的内置大脑模型,负责多种代理的高级认知和协作。 (b)一组分布式的庆祝者模块,专门实施专业机器人技能。 (c)实际 - 时间内存机制,以提高识别环境情况的能力。与1.0相比,Robbeos 2.0在系统级别的末端至端推理链接具有优化,总体绩效提高了30%。基于在云云协作模块上以国旗量表为单位,整个链接中的平均响应延迟低于3 ms,最终云的通信效率增加了27倍。在功能级别上,已经添加了用于支持动态环境中的感知和真实时时间建模的图形交换机制。同时,引入了一个多移民任务监视模块,以实现任务中的闭路反馈,从而有效提高了机器人任务执行的稳定性和成功率。多个抢劫机的协作实施过程意味着四个重要阶段:首先,复杂的任务逐步分解,然后在任务分解层中,然后基于网络。拓扑的结构动态分配了子塔萨,然后一组分布式代理在真实-Timel中并行执行每个子塔阿阿,最后共享存储机制Y时间更新环境状况和任务的进度通过Robbery 2.0中的协作框架,Robobrain 2.0完全使用了强大的空间理解,时间计划和闭路电路Robobrain 2.0的闭路推理能力,并完成了由庆祝者创建的庆祝者技能完美整合的全球机器人模型的完美整合,从而使他能够下载完整的Brains Lainds lableds lables lables链接。 Robbrain 2.0可以通过理解像素级别的空间来支持下游小脑模型的高精度,管理,放置和其他操纵。同时,它根据对任务执行状态的实际识别,适应环境的动态更改并执行闭路反馈机制,调整执行计划。 4。Robobrain2.0和Robbeos 2.0完全开源,可以协作建立一个融合的智能生态系统。当前,Robobrain 2.0和Theft 2.0是开源的,所有模型都有PESO,培训代码和评估点。 Robobrain 2.0:页面:https://supererbobrain.github.iogithub:https://github.com/flagopen/flagopen/robobrain2.0arxiv:https://arxiv.org/abs/2507.02029checkpoint-7b: https://huggingface.co/baai/robobrain2.0-7bcheckpoint-32b: https://huggingface.co/baai/bobrain2.0-322bobrain2.0 Flagrelease Multi-chip-flag-ttps: //huggingface.co/flagrece/robobbrain2 https://huggingface.co/flagrelease/robobrain2.0-7b-flagos-assendroboos 2.0:page:https://flagopen.github.io/roboosgithub:https://github.com/github.com/flagopen/roboosgithub light light jordy: https://github.com/flagopen/roboos/tree/stand-alonegithub技能商店:https://github.com/flagopen/roboskilar:https://arxiv.org/abs/250505.03673bobrain 2.0和Robbery 2.0曾经是一个普遍的启用。目前,Zhiyuan研究所已建立策略IC与全球20多家机器人公司的IC关联,并与全球开发商,研究人员和行业合作伙伴一起参加了Robobrain 2.0的开放社区,并参与了Robobrain 2.0的开放社区,以创建一个具体,开放和繁荣的智能生态系统。

Zhiyuan Robobrain 2.0+Roboos 2.0 Sen。

最近,Zhiyuan研究所推出了Robobrain 2.0 32b版本的化身大脑,并为抢劫2.0的独立版本(大规模协作框架和跨性别学的大脑)推出了独立版本。 Robobrain 2.0已完全建立了许多授权和具体的智能参考点的注册,这是一种“化身的通用大脑”,将意识,推理和计划整合在真实的物理环境中,而版本32B则在时空上的认知进步。上面启动的7B版本具有紧凑,高效的模型构建。它的光设计完全适应边缘设备的实现需求,并且可以在低收入环境中稳定。同时,与开源和封闭代码模型相比,性能仍然很强。作为第一个代码框架Tobasas Intelligente del Mundo,Roboos 2.0创新整合了MCP和体系结构的协议s没有服务器来实现光线实现,并在智能大脑和异质本体论之间打开协作路线。同时,它推出了独立的产品线和Koboskillskillskillskillskillskillskillskillskillskillskills,它们提供了智能一致的适应能力,并通过深层集成可以单击Roboticskills模块,通过深层集成,标准化界面有效地消除了制造过程中的差异。同时,他立即启动了盒子的反射,承认三行指令并迅速实施,这使开发人员可以有效地构建智能机器人系统。内置的大脑与大型和小脑协作之间的双运动连接框架“独立智能”到“团体智能”,它加速了智能技术实验室体现的智能技术实验室的运动,这使其成为开放和有效的集成并形成一个智能的生态系统。 1。Robobrain2.0打破了三个特征的瓶颈。模块化体系结构改善了复杂和化身的推理。当涉及到真正的物理环境时,有三个主要的瓶颈。空间理解的精度不足,时间较弱以及缺乏长链推理能力。 Robbrain 2.0通过这三个关键功能实现了不可或缺的进步,从而显着提高了他们对复杂和体现任务的理解和执行。空间理解:点和划界框的精确预测:根据复杂说明在图像中查找对象或区域的能力。我了解空间关系:了解对象之间的相对位置和方向。空间推断:基于场景图形的构造和实时更新,以执行复杂的3D空间推断。时间建模:长期计划:实施多个步骤任务计划的能力支持长期目标。闭路交互:接受基于反馈的动态调整,以适应动态环境。多个代理的协作:您可以协调多个代理的行为和完全复杂的任务。长链推断:链推断:可以执行多个步骤的推断,以便为复杂的任务允许步骤 - 逐步解决方案。因果逻辑:提取复杂指令的因果逻辑并与环境状态保持一致的能力。决策的透明度:支持生成推理过程详细描述的能力,以及决策的透明度和解释性。 Robobrain的一般描述呈现照片Robobrain 2.0使用模块化编码器解码器的体系结构在感知,推理和规划复杂和具体的任务中实现统一性。与传统视觉语言模型(VLM)不同,该模型的重点是通用静态视觉问题和答案(VQA),Robobrain 2.0专注于合并推理任务,例如空间感知,临时建模和长链的因果推理,同时保持强大的通用VQA的强大功能。该体系结构在集成的多模式标记序列中编码高分辨率图像,多个视觉条目,视频框架,语言说明和场景图形序列,用于积分处理。 Robraiaritectura del modethe n2.0图2。Robobrain2.0确认了多模式数据集的存款和相培训策略Robobrain 2.0信任一组全面而多样的多模式数据,整合了多个视频序列,基于高分辨率图像,高视幻像序列,场景序列,场景序列,3D语言模式和复杂的语言数据和复杂的语言数据和复杂的语言数据和复杂的语言数据。特定的环境。该多模式数据集侧重于三个中央区域,并为复杂的物理场景提供了强有力的支持。一般的多模式理解ding:整合标准的视觉问题和答案,区域咨询,OCR视觉问题和答案以及多个视觉对话回合,以优化言语表达的多样性和语义一致性。通过视觉语言互动的丰富数据,改善了模型对Tacomplex区域的理解和响应能力,可以适应各种场景,从简单的问题和答案到多个对话回合。空间感知:承认高精度对象的定位,有限的图像的预测以及对象的功能识别,涵盖了复杂的内部和外部视觉场景和3D空间推理,机器人精确地分析了对象的关系,空间属性,场景的上下文,挑战和多个位置的互动,并置换了定位。时间建模:接收多模式数据,较长的任务计划,闭路反馈M多种代理的机能和协作,改进任务模型的分解,动态环境中动作序列的预测和实际时间交互,保证在复杂的物理场景中制定决策,灵活的协作以及任务的有效执行。 Robbrain 2.0改善了互动推理的机器人,多种代理的协作以及在特定环境中计划的有效任务,具有出色的多模式识别,出色的空间推理和强大的长期计划能力,在复杂的物理场景中帮助智能看法和决策。 Robobrain 2.0训练数据集Robobrain 2.0用于大规模的Zhiyuanel培训框架的Effaza用于使用三阶段的渐进式训练过程,使用国旗量表进行大规模分布式训练。阶段1:第1阶段的基本空间学习,Robobrain 2.0着重于创建空间基本能力感知和时间理解。该模型通过一个出色的Cmultimodal数据进行了培训,该数据对图形数据,视频问题和答案以及参考识别理解任务进行了密集评分。在通过训练的这个阶段,该模型可以处理静态图像和视频传输,掌握基本的空间关系和对象运动事件,并为后续且更复杂的任务建立坚实的基础。第2阶段:在第二个合并阶段中的时空扩展,Robobrain 2.0进一步提高了通过引入多个高分辨率图像,第一人称视频数据以及导航和交互任务的任务中的空间建模功能。该模型学会了处理长时间的空间信息序列,并支持多种代理,在动态环境中的长期计划和自适应决策的协调。这个训练阶段允许模型将更好的历史视觉信息与当前说明相结合,这取得了更多在动态和互动环境中,一致的长期计划和对鲁棒场景的理解。第3阶段:在本质化上下文中的第三阶段的推论Robobrain 2.0进一步提高了复杂任务中的推理能力,并通过改进的调整和良好的调整体现。该模型是使用多个推理训练的,这些示例涵盖了诸如长期任务计划,操作预测,闭路交互,对时空和多次协作的理解等任务。在这个训练阶段,该模型可以生成推理链,并逐步支持复杂任务的逐步推理和决策,从而实现更有效,更精确的推理和计划功能。 Robbrain 2.0使用FlangeValm Frameworkm完全验证空间和时间推理功能。空间推断:眨眼(83.95),简历台(85.75),其中2Place(73.59)和Robobrain-32b/7b-2.0,Sota是RE山顶上获得了精确对象的位置,对定界线绘画和空间参考的预测,诸如双子座和GPT-4O之类的Buse线。时间推理:多个机器人计划(80.33),Egoplan 2(57.23),Robobench(72.16),出色的远程计划,闭路电路反馈和多个代理的协作能力,导致了QWEN2.5-VL,Claude,Claude和其他模型。 Robobrain 2.0-32b在空间和时间推理参考点(例如闪烁的空间,Robospia和参考库)上实现了最大的性能。 Robobrain 2.0 7b模型分别以83.95和85.75点的速度超过了Banco眨眼和CV的参考点。 Robobrain 2.0 32B模型Modelrobbrain 2.0 7b用Robospial,Ref-Spatial Banch,SAT,其中2Place和ShareBot-Bench实现了SOTA的进步。 Robobrain 2.0 7b模型首次以多机枪计划中的81.50分进行了分类,其次是Robobrain 2.0 32B,分别为80.33点。 Robobrain 2.0 32b比GPT-4O等基线具有显着优势,领导了EGO 2计划(57.23分)。 Robobrain 2.0 7B模型在抢劫银行中进行了分类72.16,已使用双模型更新,以实现高性能和更新的性能限制。双引擎Robobrain 2.0和Robbery 2.0允许抢劫2.0 Berina的大型合作框架和啤酒的多个Conlogios计划能力。 Robbrain 2.0允许跨社区任务支持多种情况的实施,例如超市,厨房和房屋。交叉方向,大脑协作框架2.0是基于智能SaaS平台的Mundo的第一个开瓶器,并结合了一个原始框架,该框架承认实现了轻型和独特的服务器轻机器人本体。同时,Roboos 2.0也是世界上第一个支持MCP的Cross -Brain合作框架,目的是建立App Store融合情报领域的生态系统。盗窃2.0实现了针对小脑技能的大脑云和适应性登记机制的优化推断的开发,从而大大降低了发展阈值。在典型的情况下,所涉及的代码数量仅是传统手动注册方法的1/10。 Marco Roboos 2.0(SaaS + MCP模式)。 Roboos是一个小脑等级系统,用于多个机器人的协作,其中包括三个主要组件。 (a)基于云计算的内置大脑模型,负责多种代理的高级认知和协作。 (b)一组分布式的庆祝者模块,专门实施专业机器人技能。 (c)实际 - 时间内存机制,以提高识别环境情况的能力。与1.0相比,Robbeos 2.0在系统级别的末端至端推理链接具有优化,总体绩效提高了30%。基于在云云协作模块上以国旗量表为单位,整个链接中的平均响应延迟低于3 ms,最终云的通信效率增加了27倍。在功能级别上,已经添加了用于支持动态环境中的感知和真实时时间建模的图形交换机制。同时,引入了一个多移民任务监视模块,以实现任务中的闭路反馈,从而有效提高了机器人任务执行的稳定性和成功率。多个抢劫机的协作实施过程意味着四个重要阶段:首先,复杂的任务逐步分解,然后在任务分解层中,然后基于网络。拓扑的结构动态分配了子塔萨,然后一组分布式代理在真实-Timel中并行执行每个子塔阿阿,最后共享存储机制Y时间更新环境状况和任务的进度通过Robbery 2.0中的协作框架,Robobrain 2.0完全使用了强大的空间理解,时间计划和闭路电路Robobrain 2.0的闭路推理能力,并完成了由庆祝者创建的庆祝者技能完美整合的全球机器人模型的完美整合,从而使他能够下载完整的Brains Lainds lableds lables lables链接。 Robbrain 2.0可以通过理解像素级别的空间来支持下游小脑模型的高精度,管理,放置和其他操纵。同时,它根据对任务执行状态的实际识别,适应环境的动态更改并执行闭路反馈机制,调整执行计划。 4。Robobrain2.0和Robbeos 2.0完全开源,可以协作建立一个融合的智能生态系统。当前,Robobrain 2.0和Theft 2.0是开源的,所有模型都有PESO,培训代码和评估点。 Robobrain 2.0:页面:https://supererbobrain.github.iogithub:https://github.com/flagopen/flagopen/robobrain2.0arxiv:https://arxiv.org/abs/2507.02029checkpoint-7b: https://huggingface.co/baai/robobrain2.0-7bcheckpoint-32b: https://huggingface.co/baai/bobrain2.0-322bobrain2.0 Flagrelease Multi-chip-flag-ttps: //huggingface.co/flagrece/robobbrain2 https://huggingface.co/flagrelease/robobrain2.0-7b-flagos-assendroboos 2.0:page:https://flagopen.github.io/roboosgithub:https://github.com/github.com/flagopen/roboosgithub light light jordy: https://github.com/flagopen/roboos/tree/stand-alonegithub技能商店:https://github.com/flagopen/roboskilar:https://arxiv.org/abs/250505.03673bobrain 2.0和Robbery 2.0曾经是一个普遍的启用。目前,Zhiyuan研究所已建立策略IC与全球20多家机器人公司的IC关联,并与全球开发商,研究人员和行业合作伙伴一起参加了Robobrain 2.0的开放社区,并参与了Robobrain 2.0的开放社区,以创建一个具体,开放和繁荣的智能生态系统。

Zhiyuan Robobrain 2.0+Roboos 2.0 Sen。

2025-07-16